-

00

days

- .

-

00

hours

- .

-

00

minutes

- .

-

00

seconds

2025-11-21 2506

翻译:杨振涛 审校:周冉

原文:https://solutionsreview.com/ai-may-be-the-lead-singer-but-you-still-need-the-band/

最佳实践

Linux 基金会的 Clyde Seepersad 评论说,AI (人工智能)可能是主唱,但你仍然需要乐队。本文最初发表于 Insight Jam,这是一个企业 IT 社区,旨在促进人们就AI展开对话。

观察人们对 AI 的热情和兴趣,我感觉就像在看Bono的表演一样(译者注:Bono 是 U2乐队主唱)。他是当之无愧的明星,人人都想分一杯羹。在狂热的摇滚乐现场,人们常常忽略了(像Edge、Adam和Larry这样的)幕后团队,他们默默地为这场盛事付出了更多努力(译者注:Edge、Adam和Larry分别是U2乐队的吉他手、贝斯手、鼓手)。在每一个大型语言模型、代码编写工具和 AI Agent (人工智能代理)背后,都有一大堆基础技术在创造奇迹,例如:

认识到这些依赖关系并对其进行投资的企业不仅能加快发展速度,还能更可靠、更可持续地进行创新。那些只专注于寻找最优秀的 “AI人才”,却忽视了团队支持成员的企业很可能会发现,他们并没有得到他们所期望的结果。基础模型的性能排行榜固然引人关注,但模型本身并不能实现、扩展和保障安全。

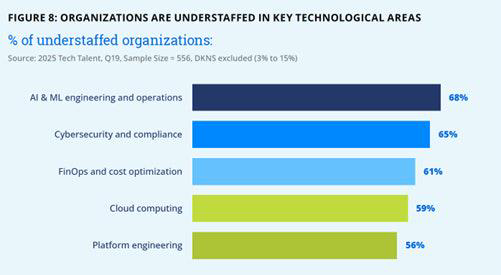

《2025 年科技人才现状报告》明确指出:虽然 AI 技能短缺,但让 AI 正常运转所需的辅助人才库也同样短缺。企业不仅在 AI/ML(机器学习) 方面人手不足,在将原型转化为产品的相关能力方面也是如此。与此同时,大多数企业都希望 AI 能够带来有意义的价值,并计划扩大云计算的使用范围。如果没有相应的配套能力,这些雄心壮志都将落空。

报告显示,68% 的企业在 AI/ML 工程方面人手不足,云计算(59%)和平台工程(56%)方面也存在类似缺口。这反映了一个生产现实:部署 AI 不仅仅是构建模型,它还需要具备以下跨学科技能的团队:

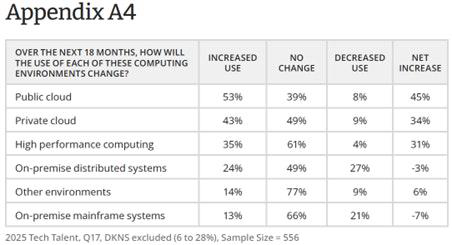

报告显示,53% 的企业计划在未来 18 个月内增加对公有云的使用。这种迁移能够实现可扩展的训练、灵活的资源分配和快速部署。无论是在 GPU 集群上训练 PyTorch 模型,还是使用 vLLM 服务 Transformer 模型,云原生基础设施都是其支柱。

从容器和编排到边缘计算和 GPU 驱动程序,几乎所有现代云计算和 AI 部署都依赖于 Linux 操作系统。对于开发人员来说,熟练掌握 Linux 正日益成为一项基本要求。这不仅对系统管理员至关重要,对需要管理依赖关系、优化性能和调试复杂交互的数据科学家和 ML 工程师来说也是如此。

基础模型可能会成为头条新闻,但这些工具使开发变得可重复和可协作。尤其是 PyTorch,凭借其灵活性、强大的社区和丰富的 Python 生态系统,已成为研究和生产领域的热门选择,而这正是团队在架构演进过程中快速迭代所需要的。

随着企业从实验阶段过渡到实际服务阶段,推理性能成为瓶颈。vLLM 等工具可以减少延迟并提高吞吐量,从而高效地服务于大型语言模型,尤其是在大规模和低延迟环境中。采用这些工具标志着 AI 技术栈日趋成熟——该技术栈专为训练和经济高效的实时推理而设计

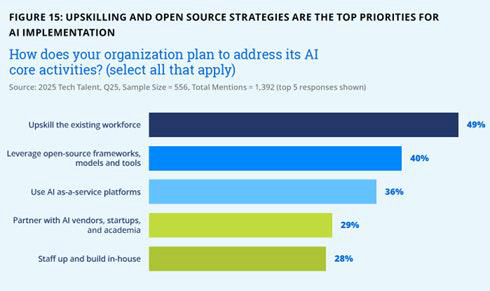

报告还说明了开源模式的优势。包括 Kubernetes、PyTorch 和 vLLM 在内的大多数核心工具都是开源的。它们的开发是由社区驱动的,创新过程是透明的,知识共享加速了它们的普及应用。报告显示,各企业都倾向于采用这种方法: 49% 的企业优先考虑技能提升,40% 的企业依靠开源框架、模型和工具来推进 AI 计划。在发展内部能力的同时,利用开放的生态系统,正是大规模应用得以实现的关键所在。

对于领导者来说,关键在于务实:仅仅聘请一名 AI 工程师是不够的。你需要了解模型扩展的云架构师、精通 Linux 并能配置和加固环境的开发人员,以及 DevOps 专业人才,他们可以通过 CI/CD 运行 ML 流水线,并遵循与任何关键服务相同的规则。最重要的是,你需要这样一支员工队伍,他们将 AI 视为更广泛转型的一部分,而不是一种独立的能力。

AI 是一种工具,而非战略。它只有被技能娴熟的人员运用于这样一个强大的生态系统中才能发挥作用:云原生基础设施、Linux、开源框架以及可扩展的部署路线。任何一个环节的缺失都会导致结果不稳定。那些像重视算法一样重视基础设施建设的领导者,才能将 AI 从期望转化为持久的现实影响力。

更多洞察和战略建议,欢迎点击 这里 获取完整《2025 年度技术人才报告》,一起探索技术与人才的未来走向!

Linux基金会开源软件学园 Copyright © 2019-2026 linuxfoundation.cn, ICP license, no. 京ICP备17074266号-2