-

00

days

- .

-

00

hours

- .

-

00

minutes

- .

-

00

seconds

2025-06-26 936

2025 年 6 月 10 - 11 日,KubeCon + CloudNativeCon China 2025 在香港隆重召开。

CNCF 首席技术官 Chris Aniszczyk 出席大会,讲解 CNCF 最新进展。现场,OSCHINA 等多家媒体采访了 Chris Aniszczyk,共同探讨开源生态、云计算发展,AI 与云融合等话题。

今年是 CNCF 成立的第 10 年。在全球的贡献者方面,CNCF 是最大的开源组织之一,所有项目的全球贡献者人数大约是287000人。目前,全球有全球有 900 万至 1000 万名云原生开发者正在开发云原生应用程序,而 Kubernetes 几乎随处可见,公有云和私有云厂商都在持续扩展相关应用。

回顾过去的发展,Chris Aniszczyk 提到了 3 个重要的决策。

一是将基金会重点扩展到边缘项目上,明确沙箱孵化的机制和流程,比如早期 Linkerd 的加入,让 CNCF 生态开始覆盖服务网格领域,填补了容器编排与微服务治理之间的技术空白。

另一件事是扩大组织范围,2015-2017 年的“容器战争”期间,许多项目在容器编排技术标准方面存在分歧和竞争。CNCF 在 2017 年决定引入容器运行时项目 Containerd 项目,这是由 Docker 捐赠,最初是 Docker 引擎的核心组件之一,后来成为独立的工业标准容器运行时。后续,CNCF 还引入了 CRI-0、Kata Containers 等容器运行时项目。事后证明,这带来了容器运行时的多元化发展。

此外,Chris Aniszczyk 还提到了第三件事,这是一个长期的理念——确保 CNCF 是一个全球性组织,“我们很早就在努力确保我们是一个全球性组织,我们持续扩大全球影响力,并确保贡献者来自世界各地,支持文档的多语言翻译……这些努力可以真正确保这件事。”

如今,在 AI 热潮下,CNCF 正在推动云计算与 AI 的融合,比如 Kubernetes、OpenTelemetry 等项目正在支撑并推动人工智能基础设施的发展。

云原生 + AI,优化基础设施

Chris Aniszczyk 指出,Kubernetes 本身就是当下应用程序的骨干,如今在 Kubernetes 上同时运行着传统应用程序、容器化应用程序和 AI 工作负载。

对于 Kubernetes 上运行 AI 工作负载的人来说,有一个大问题:即如何实际地分发和提供 AI 模型?怎么实际打包它们,如打包应用容器?为了解决这些问题,CNCF 有一个新的项目叫做 ModelPack。Chris Aniszczyk 介绍,这是多家不同公司之间的合作努力,包括 Red Hat、Google 等公司参与。“这仅仅是延续了一种趋势:我们能否将 CNCF 中学到的所有这些宝贵的课程和项目应用到大规模运行 AI 工作负载中?我们能否像过去那样对工作负载进行观测、保护和分发?”

此外,从 AI 的角度来看,Chris Aniszczyk 还宣布另一件很酷的事情:CNCF 已经建立了一个开源一致性认证体系。通过 Kubernetes 兼容性计划,目前已有 100 多个产品和项目获得 Kubernetes 兼容认证。

现阶段,由于不同团队在模型分发、推理任务部署等方面存在显著差异。所以 CNCF 计划通过定义统一的 API 接口,确保兼容此标准的工作负载能够无缝迁移——比如一个应用在某个 Kubernetes 集群中运行良好,即可轻松迁移至另一个集群。

Chris Aniszczyk 认为,这本质上是将容器可移植性的成功经验复用于 AI 领域,为 AI 工作负载构建跨平台的标准化能力。“我们希望在 Kubernetes 的背景下对 AI 工作负载做同样的事情,因此我们已从本月开始启动了这项工作。我们呼吁全球社区参与进来,帮助我们定义在 Kubernetes 上运行符合标准的 AI 工作负载意味着什么。”

除了标准化方面的进展,也有企业已通过 CNCF 项目在 AI 基础设施层面实现突破性优化。

在科大讯飞,随着 AI 需求不断增长,其在业务快速增长过程中遇到了扩展难题。调度效率低导致 GPU 资源利用不足,工作流管理复杂,团队间资源争抢激烈,这些问题拖慢了研发进度,也给基础设施带来压力。科大讯飞选择 Volcano 来应对训练基础设施日益复杂和庞大的挑战。工程团队需要更高效的资源分配方案,管理多阶段复杂训练工作流,减少任务中断,并保障不同团队的公平资源使用。借助 Volcano 实现了:GPU 利用率提升 40%,显著降低基础设施成本和计算资源闲置;任务失败恢复速度提升 70%,确保训练过程不中断;超参数搜索加速 50%,推动更快的迭代和创新。

凭借这个案例,科大讯飞也赢得 CNCF 最终用户案例研究竞赛。Chris Aniszczyk 认为科大讯飞的案例展示了开源技术如何解决复杂且关键的规模化挑战。“通过 Volcano 提升 GPU 效率和优化训练工作流,他们降低了成本,加快了开发,并在 Kubernetes 平台上构建了更可靠的 AI 基础设施,这对所有致力于 AI 领先的组织都至关重要。”

这些实践也印证了云原生技术对 AI 规模化落地的关键价值——通过弹性资源调度、异构设备管理及自动化运维,企业得以将有限算力转化为持续创新的核心动力。

CNCF 10 年:开源与全球化基石

Chris Aniszczyk 还探讨了开源的核心驱动力、云原生的未来、人才培育以及中国的云原生贡献等情况。

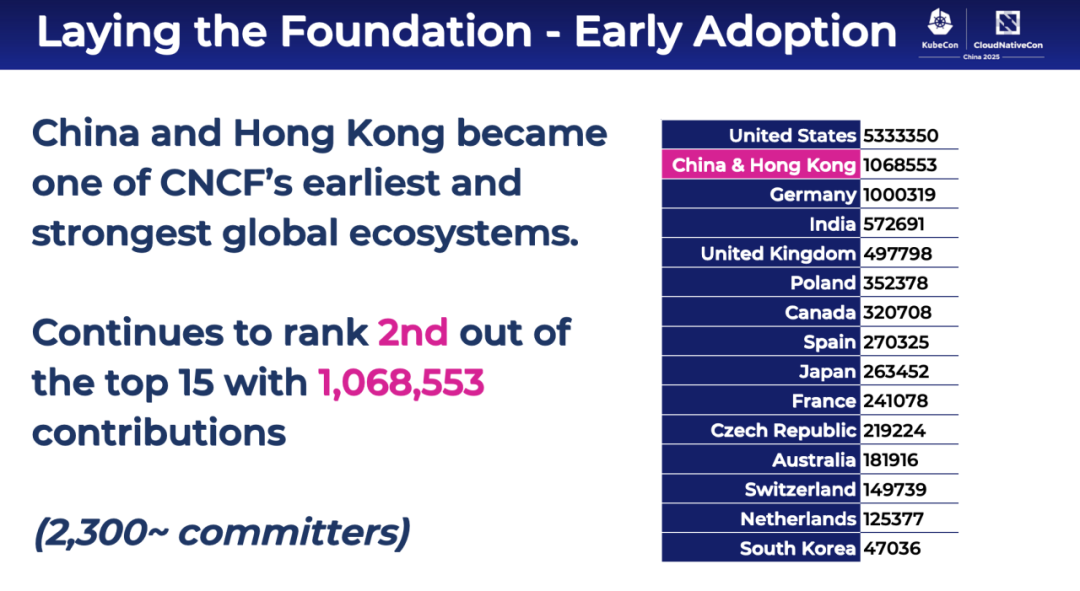

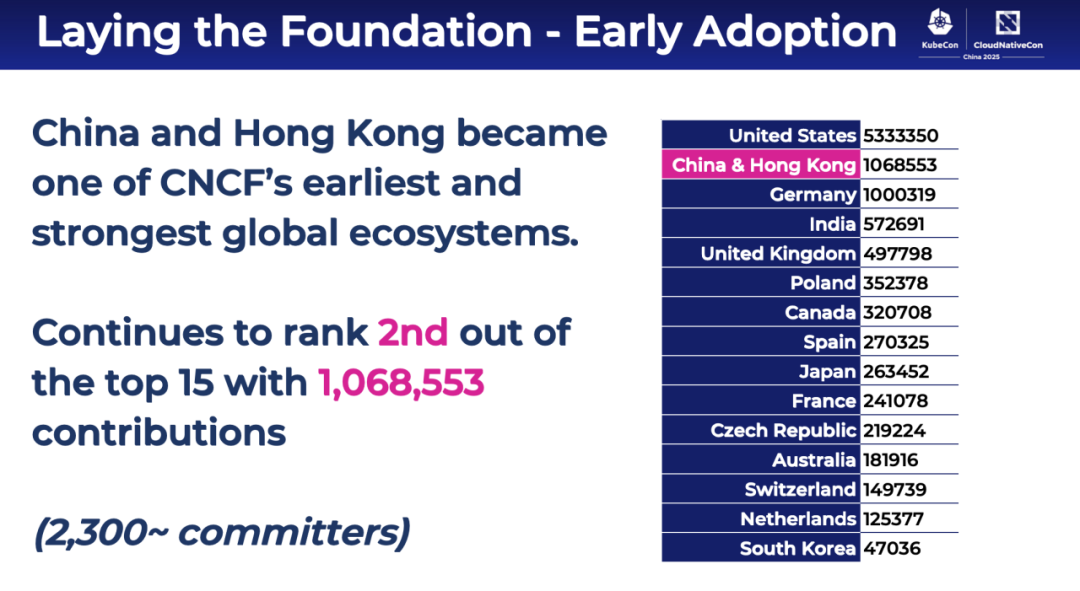

Chris Aniszczyk 高度认可中国在云原生技术领域的创新与贡献。中国在科技创新,尤其云原生领域展现重大贡献,是 CNCF 最早且最强大的生态系统之一,开源贡献位居全球第二,孕育出如 Volcano、Dragonfly、KubeEdge、OpenYurt 等多个具有全球影响力的项目,彰显了在批处理调度、分发大型镜像、边缘计算等多方面的卓越能力。

在 Chris Aniszczyk 看来,想要构建一个开源项目,尤其是大规模的,其核心驱动力是欢迎新团体、新的贡献者,哪怕对方是商业上的竞争对手。

此外,CNCF 也深入社区成员中去做调研,最终发现社区成员寻求帮助的最大问题之一是教育。

去年 3 月,CNCF 启动 Kubestronaut 计划,提供各种类型的 Kubernetes 的认证,涵盖多方面的知识教育。现在,已经有来自100多个国家超过1800名开发者获得认证。

关于未来的发展。Chris Aniszczyk 指出,CNCF 在前 10 年里主要致力于在全球范围内推动整个行业的发展,包括聚集云服务提供商、初创企业、从事云业务的供应商等各方,共同合作以构建标准化的基本组件,从而真正实现容器化工作负载,所以现在 Kubernetes 已经在各大公共和私有云中普及开来。

接下来,也是要继续团结协作,对基于容器化工作的基本组件进行标准化,尤其是 AI 领域。比如 Kubernetes 在 DRA 子项目上投入了大量资源,旨在解决异构硬件,如 GPU、FPGA、NPU 等在云原生环境中的精细化调度与管理问题。未来,还有许多诸如此类的工作需要做。

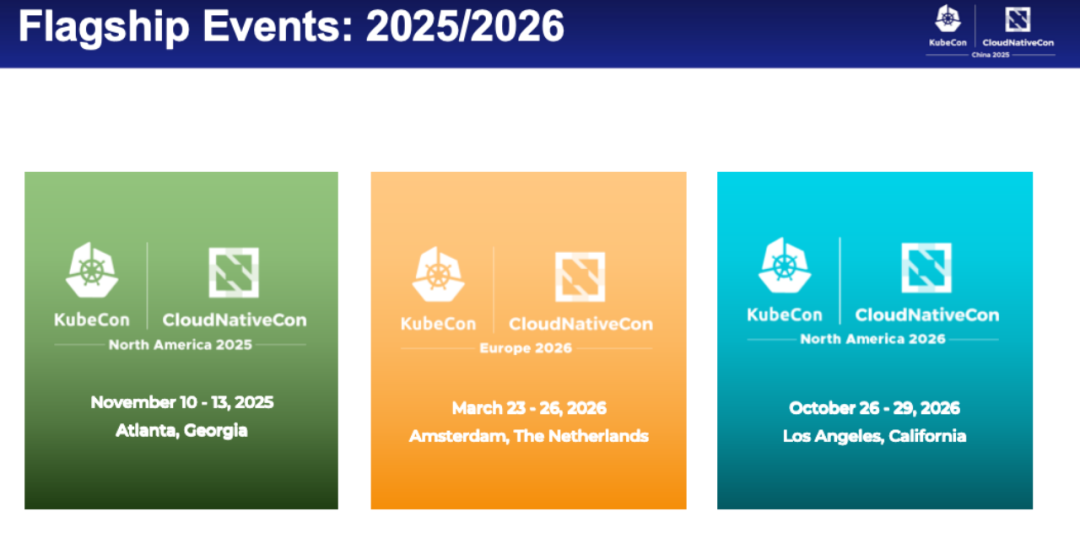

最后,Chris Aniszczyk 也公布了接下来的活动计划,并指出云原生技术极其全球化,希望 CNCF 未来能进一步扩大其全球影响力。

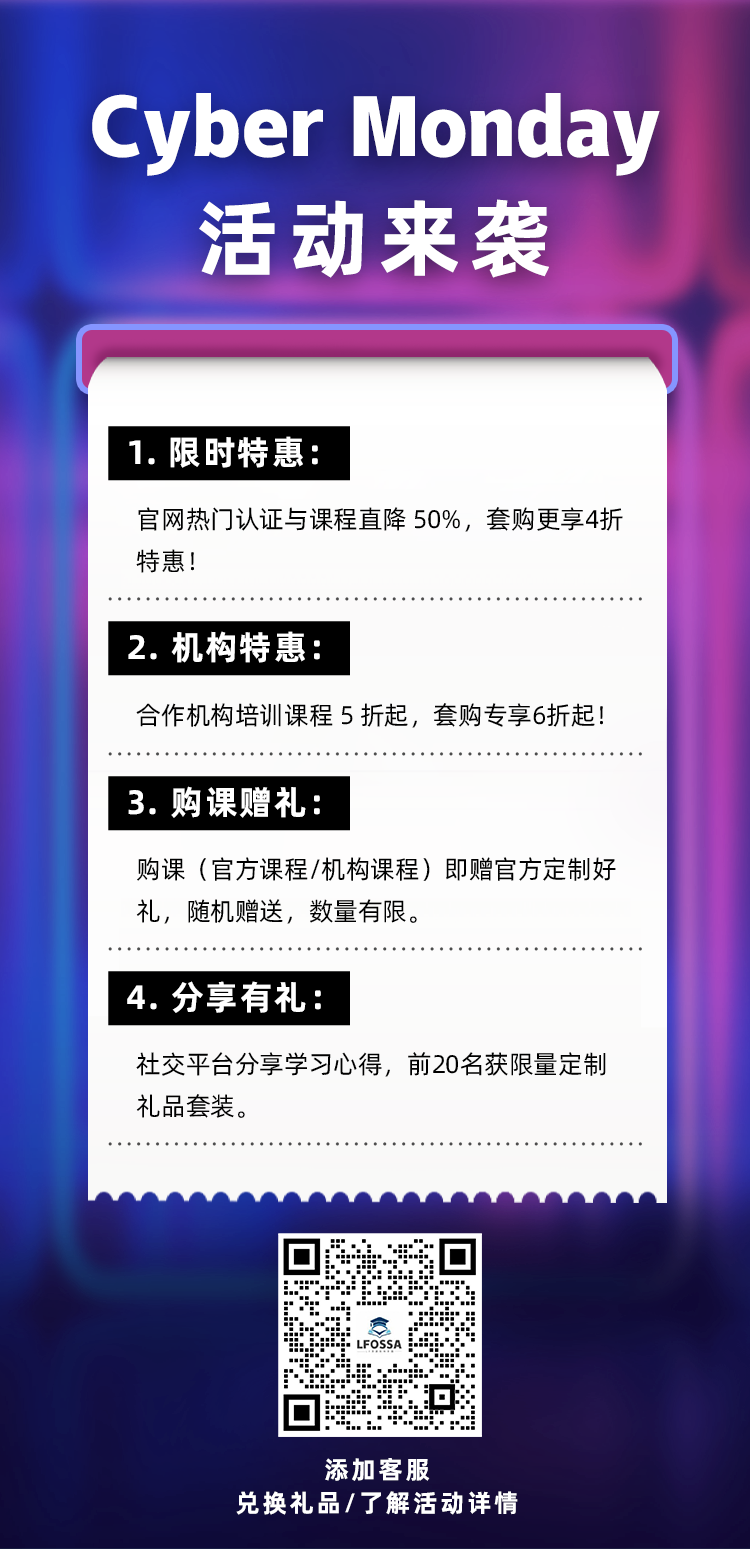

为更好支持开发者与组织在变革中把握机遇,LFOSSA 于 6 月 18 日至 6 月 30 日 推出 LFOSSA 五周年 618 开源人才狂欢节特别活动,开启全场 LF 官方认证考试及课程 低至 6折 的限时福利,以实际行动回馈广大开发者与社区伙伴的长期信任与支持。

有关 LFOSSA 五周年 618 开源人才狂欢节活动,可点击以下链接了解详情:

LFOSSA 五周年 618 开源人才狂欢节 限时福利活动现已开启!

查看更多 LFOSSA 培训、认证及套购产品:

https://training.linuxfoundation.cn/courses

认证:

https://training.linuxfoundation.cn/certificates

套购:

https://training.linuxfoundation.cn/pack

立即点击 这里 进入LFOSSA官网,选购官方认证考试及培训课程产品。

Linux基金会开源软件学园 Copyright © 2019-2026 linuxfoundation.cn, ICP license, no. 京ICP备17074266号-2